Dominio de la medición: Su guía definitiva para el error absoluto, relativo y de escala completa (%FS)

¿Alguna vez has mirado la hoja de especificaciones de unapresióntransmisor,afluirmetro, oasensor de temperaturay¿Ha visto una línea como "Precisión: ±0,5 % FS"? Es una especificación común, pero ¿qué significa realmente para los datos que recopila? ¿Significa que cada lectura está dentro del 0,5 % del valor real? Como se ve, la respuesta es un poco más compleja, y comprender esta complejidad es crucial para cualquier persona involucrada en ingeniería, fabricación y medición científica.

El error es inevitable en el mundo físico. Ningún instrumento es perfecto. La clave está en comprender la naturaleza del error, cuantificarlo y asegurarse de que se encuentre dentro de los límites aceptables para su aplicación específica. Esta guía desmitificará los conceptos básicos.ofmediciónerrorComienza con las definiciones fundamentales y luego se expande con ejemplos prácticos y temas cruciales relacionados, transformándote de alguien que simplemente lee las especificaciones a alguien que realmente las comprende.

¿Qué es el error de medición?

En el fondo,El error de medición es la diferencia entre una cantidad medida y su valor real verdadero.Piense en ello como la brecha entre el mundo tal como lo ve su instrumento y el mundo tal como es en realidad.

Error = Valor medido – Valor real.

El "Valor Verdadero" es un concepto teórico. En la práctica, el valor verdadero absoluto nunca se puede conocer con total certeza. En su lugar, se utiliza un valor verdadero convencional. Este es un valor proporcionado por un estándar de medición o instrumento de referencia que es significativamente más preciso (normalmente de 4 a 10 veces más preciso) que el dispositivo que se está probando. Por ejemplo, al calibrar unportátilpresiónindicador, el “valor verdadero convencional” se obtendría de un método de alta precisión,de grado de laboratoriopresióncalibrador.

Comprender esta sencilla ecuación es el primer paso, pero no lo explica todo. Un error de 1 milímetro es insignificante al medir la longitud de una tubería de 100 metros, pero supone un fallo catastrófico al mecanizar un pistón para un motor. Para comprenderlo todo, necesitamos expresar este error de forma más significativa. Aquí es donde entran en juego los errores absolutos, relativos y de referencia.

Recopilación de tres errores de medición comunes

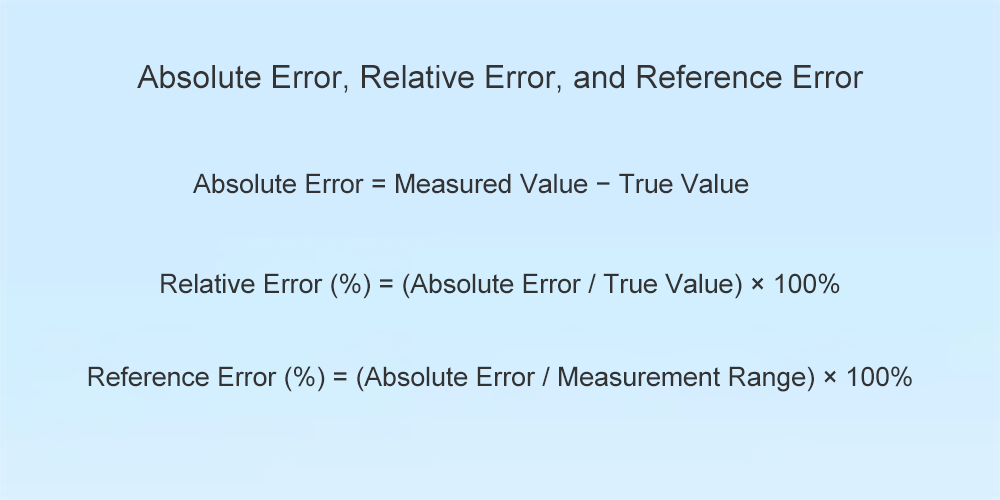

Analicemos las tres formas principales de cuantificar y comunicar el error de medición.

1. Error absoluto: la desviación bruta

El error absoluto es la forma más simple y directa de error. Según se define en el documento fuente, es la diferencia directa entre la medición y el valor real, expresada en las unidades de la medición.

Fórmula:

Error absoluto = Valor medido − Valor verdadero

Ejemplo:

Estás midiendo el flujo en una tubería con unverdaderocaudalof50 m³/h, ysumedidor de flujolee50,5 m³/h, por lo que el error absoluto es 50,5 – 50 = +0,5 m³/h.

Ahora, imagine que está midiendo un proceso diferente con un caudal real de 500 m³/h, y su medidor de caudal indica 500,5 m³/h. El error absoluto sigue siendo de +0,5 m³/h.

¿Cuándo es útil? El error absoluto es esencial durante la calibración y las pruebas. Un certificado de calibración suele indicar las desviaciones absolutas en varios puntos de prueba. Sin embargo, como muestra el ejemplo, carece de contexto. Un error absoluto de +0,5 m³/h parece mucho más significativo para el caudal menor que para el mayor. Para comprender esta importancia, necesitamos el error relativo.

2. Error relativo: el error en contexto

El error relativo proporciona el contexto del que carece el error absoluto. Expresa el error como una fracción o porcentaje del valor real medido. Esto indica la magnitud del error en relación con la magnitud de la medición.

Fórmula:

Error relativo (%) = (Error absoluto / Valor verdadero) × 100%

Ejemplo:

Repasemos nuestro ejemplo:

Para el caudal de 50 m³/h: Error relativo = (0,5 m³/h / 50 m³/h) × 100% = 1%

Para el caudal de 500 m³/h: Error relativo = (0,5 m³/h / 500 m³/h) × 100% = 0,1%

De repente, la diferencia es mucho más clara. Si bien el error absoluto fue idéntico en ambos escenarios, el error relativo muestra que la medición fue diez veces menos precisa para el caudal más bajo.

¿Por qué es importante? El error relativo es un indicador mucho más preciso del rendimiento de un instrumento en un punto operativo específico. Ayuda a responder a la pregunta "¿Qué tan buena es esta medición en este momento?". Sin embargo, los fabricantes de instrumentos no pueden indicar un error relativo para cada valor posible que se pueda medir. Necesitan una métrica única y fiable para garantizar el rendimiento de su dispositivo en toda su capacidad operativa. Esa es la función del error de referencia.

3. Error de referencia (%FS): el estándar de la industria

Esta es la especificación que se ve con más frecuencia en las hojas de datos: precisión expresada como porcentaje.ofLlenoEscala (%FS), también conocido como error de referencia o error de amplitud. En lugar de comparar el error absoluto con el valor medido actual, lo compara con el rango total del instrumento.

Fórmula:

Error de referencia (%) = (Error absoluto / Rango de medición) × 100%

El rango de medición (o span) es la diferencia entre los valores máximos y mínimos que el instrumento está diseñado para medir.

El ejemplo crucial: comprender %FS

Imaginemos que comprasatransmisor de presiónconlas siguientes especificaciones:

-

Rango: 0 a 200 bar

-

Precisión: ±0,5 % FS

Paso 1: Calcular el error absoluto máximo permitido.

En primer lugar, encontramos el error absoluto al que corresponde este porcentaje: error absoluto máximo = 0,5% × (200 bar – 0 bar) = 0,005 × 200 bar = ±1 bar.

Este es el cálculo más importante, que nos dice que sin importar la presión que estemos midiendo, se garantiza que la lectura de este instrumento estará dentro de ±1 bar del valor real.

Paso 2: Vea cómo esto afecta la precisión relativa.

Ahora, veamos qué significa este error de ±1 barra en diferentes puntos del rango:

-

Medición de una presión de 100 bar (50 % del rango): La lectura puede estar entre 99 y 101 bar. El error relativo en este punto es (1 bar / 100 bar) × 100 % = ±1 %.

-

Medición de una presión de 20 bar (10 % del rango): La lectura puede estar entre 19 y 21 bar. El error relativo en este punto es (1 bar / 20 bar) × 100 % = ±5 %.

-

Medición de una presión de 200 bar (100 % del rango): La lectura podría estar entre 199 y 201 bar. El error relativo en este punto es (1 bar / 200 bar) × 100 % = ±0,5 %.

Esto revela un principio crítico de la instrumentación: la precisión relativa de un instrumento es mejor en la parte superior de su rango y peor en la parte inferior.

Consejo práctico: ¿Cómo elegir el instrumento adecuado?

La relación entre %FS y el error relativo tiene un profundo impacto en la selección del instrumento.Cuanto menor sea el error de referencia, mayor será la precisión general del instrumento.Sin embargo, también puede mejorar la precisión de su medición simplemente eligiendo el rango correcto para su aplicación.

La regla de oro para dimensionar las mediciones es seleccionar un instrumento cuyos valores operativos típicos se encuentren en la mitad superior (idealmente, los dos tercios superiores) de su rango de escala completa. Veamos un ejemplo:

Imagine que su proceso normalmente opera a una presión de 70 bar, pero puede tener picos de hasta 90 bar. Está considerandodostransmisores, ambos con una precisión de ±0,5 % FS:

-

Transmisor A: Rango 0-500 bar

-

Transmisor B: Rango 0-100 bar

Calculemos el error potencial para su punto de funcionamiento normal de 70 bar:

Transmisor A (0-500 bar):

-

Error absoluto máximo = 0,5% × 500 bar = ±2,5 bar.

-

A 70 bar, la lectura podría tener una desviación de 2,5 bar. El error relativo real es (2,5 / 70) × 100 % ≈ ±3,57 %. ¡Este es un error significativo!

Transmisor B (0-100 bar):

-

Error absoluto máximo = 0,5% × 100 bar = ±0,5 bar.

-

A 70 bar, la lectura podría tener una desviación de tan solo 0,5 bar. El error relativo real es (0,5 / 70) × 100 % ≈ ±0,71 %.

Al elegir el instrumento con el rango “comprimido” apropiado para su aplicación, mejoró su precisión de medición en el mundo real en un factor de cinco, aunque ambos instrumentos tenían la misma clasificación de precisión “%FS” en sus hojas de datos.

Exactitud vs. Precisión: Una distinción crucial

Para dominar por completo la medición, es esencial un concepto más: la diferencia entre exactitud y precisión. Si bien estos términos suelen usarse indistintamente, en ciencia e ingeniería significan cosas muy distintas.

Exactitudiscómocerca de una medición está el valor verdaderoSe relaciona con el error absoluto y relativo. Un instrumento preciso, en promedio, proporciona la lectura correcta.

PrecisióniscómoCerca de varias mediciones de la misma cosa se encuentran entre síSe refiere a la repetibilidad o consistencia de una medición. Un instrumento preciso proporciona casi la misma lectura cada vez, pero esa lectura no es necesariamente la correcta.

He aquí la analogía del objetivo:

-

Precisión y exactitud: Todos tus disparos se concentran en el centro de la diana. Ideal.

-

Preciso pero impreciso: Todos tus disparos están muy agrupados, pero se concentran en la esquina superior izquierda del objetivo, lejos de la diana. Esto indica un error sistemático, como una mira telescópica desalineada en un rifle o un sensor mal calibrado. El instrumento es repetible, pero falla constantemente.

-

Preciso pero impreciso: Tus disparos se dispersan por todo el objetivo, pero su posición promedio es el centro de la diana. Esto indica un error aleatorio, donde cada medición fluctúa de forma impredecible.

-

Ni preciso ni exacto: los disparos se dispersan aleatoriamente por todo el objetivo, sin consistencia.

Un instrumento con una especificación de 0,5 % FS afirma su precisión, mientras que la precisión (o repetibilidad) a menudo se detalla como un elemento de línea separado en la hoja de datos y, por lo general, es un número menor (mejor) que su precisión.

Conclusión

Comprender los matices del error es lo que separa a un buen ingeniero de uno excelente.

En resumen, dominar el error de medición requiere pasar de los conceptos básicos a la aplicación práctica. El error absoluto proporciona la desviación bruta, el error relativo la sitúa en el contexto de la medición actual, y el error de referencia (%FS) ofrece una garantía estandarizada del error máximo de un instrumento en todo su rango. La conclusión clave es que la precisión especificada de un instrumento y su rendimiento en condiciones reales no son lo mismo.

Al comprender cómo un error fijo de %FS afecta la precisión relativa en toda la escala, los ingenieros y técnicos pueden tomar decisiones informadas. Seleccionar un instrumento con el rango adecuado para la aplicación es tan crucial como su índice de precisión, garantizando que los datos recopilados reflejen fielmente la realidad.

La próxima vez que revise una hoja de datos y vea una clasificación de precisión, sabrá exactamente qué significa. Podrá calcular el error potencial máximo, comprender cómo ese error afectará su proceso en diferentes puntos operativos y tomar una decisión informada que garantice que los datos recopilados no sean solo números en una pantalla, sino un reflejo fiable de la realidad.

Contacte con nuestros expertos en medición

Hora de publicación: 20 de mayo de 2025